메타(페이스북), "AI 반도체 MTIA 투자 지속"···페이스북·인스타그램 랭킹·추천 광고 모델에 적용

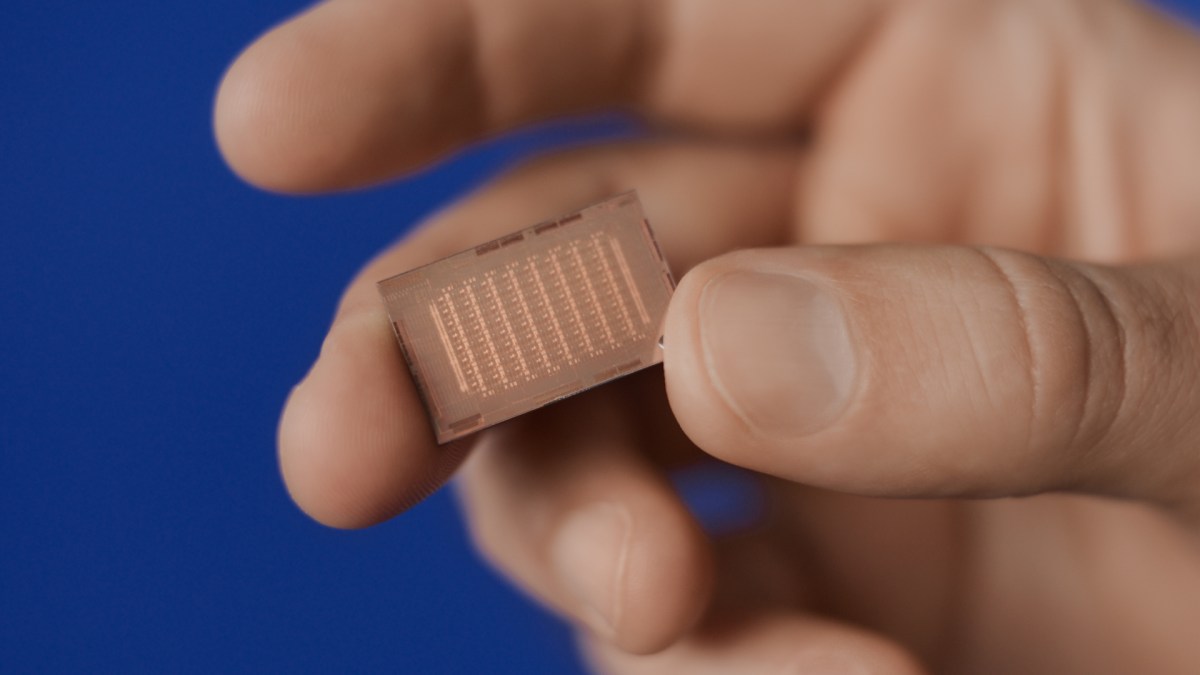

[테크수다 기자 도안구 eyeball@techsuda.com] 메타(Facebook)도 AI 학습과 추론 칩을 만들고 있다. 일명 MTIA(Meta Training and Inference Accelerator). 지난해 v1을 공개한 데 이어 차세대 MTIA는 이전 솔루션보다 컴퓨팅과 메모리 대역폭을 두 배 이상 늘리면서도 워크로드와의 긴밀한 연계를 유지한다.

메타는 이 칩의 아키텍처에 대해 기본적으로 페이스북과 인스타그램(Instagram)의 랭킹과 추천 광고 모델을 강화하기 위한 컴퓨팅, 메모리 대역폭, 메모리 용량의 적절한 균형을 제공하는데 중점을 두고 있다.

다음은 해당 메타뉴스룸에 올라온 글을 정리한 내용이다.

요약

메타는 생성형 AI, 추천 시스템, 고급 AI 연구 등을 뒷받침하기 위해 차세대 대규모 인프라를 구축하고 있습니다. 이 과정에서 자체 설계한 AI 추론 가속기 MTIA가 핵심적인 역할을 하고 있습니다. 최신 버전의 MTIA는 이전 버전 대비 연산 능력과 메모리 대역폭이 2배 이상 향상되었으며, 메타 제품의 주요 구성 요소인 랭킹 및 추천 모델을 효율적으로 처리할 수 있도록 특화되었습니다.

뉴스의 중요한 정보

・MTIA는 메타의 고유한 AI 워크로드에 맞춰 사내에서 설계된 첫 번째 AI 추론 가속기입니다.

・최신 버전의 MTIA는 이전 버전보다 연산 능력과 메모리 대역폭이 2배 이상 개선되었습니다.

・MTIA는 이미 메타의 데이터 센터에 배치되어 실제 모델을 서비스하고 있으며, 상용 GPU 대비 더 높은 효율성을 보여주고 있습니다.

・메타는 MTIA의 적용 범위를 확대하기 위해 여러 프로그램을 진행 중이며, 생성형 AI 워크로드 지원 등을 계획하고 있습니다.

자세한 정보

메타는 자사의 독특한 AI 워크로드에 최적화된 맞춤형 실리콘을 개발하는 장기 로드맵을 추진하고 있습니다. 이 과정에서 MTIA는 중요한 역할을 담당할 전망입니다.

MTIA는 현재 메타의 인프라와 협력하도록 설계되었을 뿐만 아니라, 향후 도입될 수 있는 차세대 GPU 등 더욱 발전된 하드웨어와도 호환될 수 있도록 개발되고 있습니다.

메타의 야심찬 맞춤형 실리콘 계획을 실현하기 위해서는 연산 능력뿐만 아니라 메모리 대역폭, 네트워킹, 용량 등 다양한 측면에서의 투자가 필요할 것으로 보입니다.

현재 MTIA의 적용 범위를 확대하기 위한 여러 프로그램이 진행 중이며, 생성형 AI 워크로드 지원 등도 계획되어 있습니다. 메타는 이러한 노력이 시작에 불과하다고 밝히고 있어, 앞으로의 행보가 더욱 주목됩니다.

메타는 엔비디아와의 협력도 강화하면서 자체 반도체 투자도 병행해 가고 있다.

한편, 구글 클라우드는 구글 클라우드 넥스트(Google Cloud Next) 2024에서 자사 TPU v5p의 정식 버전을 출시하고 ARM 기반 CPU인 'Google Axion 프로세서를 선보였다. 엔비디아와의 협력으로 인프라도 구축하고 있다고 밝혔다. AWS와 마이크로소프트 애저(Microsoft Azure)도 이미 AI 칩과 ARM 기반 CPU를 발표한 바 있다.

클라우드 서비스 사업자들은 AI 시대를 주도하기 위해 자체 칩 투자를 꾸준히 늘려가고 있다.

[테크수다 기자 도안구 eyeball@techsuda.com]

[테크수다 기자 도안구 eyeball@techsuda.com]