엔비디아, 루빈 CPX 공개: 대규모 컨텍스트 추론을 위한 새로운 GPU 클래스

[테크수다 기자 도안구 eyeball@techsuda.com] 엔비디아(CEO 젠슨 황)는 오늘 AI 인프라 서밋(AI Infra Summit)에서 루빈(Rubin) CPX GPU를 공개했다. 이번 신제품은 수백만 토큰 규모의 소프트웨어 코딩 및 생성형 비디오 애플리케이션을 지원하기 위해 설계된 새로운 GPU 클래스다.

이와 관련해 페친인 서진호님이 글을 올렸길래 동의 아래 이곳에 게재합니다. 서진호 님이 구글 NotebookLM 통해 영상도 만들었는데 구독과 좋아요를 부탁드립니다. ^.^ 또 엔비디아 보도자료는 하단에 오픈AI Chatgpt-5 를 통해 번역해 정리했습니다.

친구들, 오늘 에피소드는 미국 캘리포니아주 산타 클라라에서 개최되고 있는 AI Infra Summit 2025에서 발표된 엔비디아(NVIDIA)사의 차세대 GPU 루빈(Rubin) CPX 공개에 대해 이야기를 나누도록 하겠습니다.

특히, 이번 루빈 GPU는 “매시브 컨텍스트 추론(Massive-Context Inference)”라고 부르며, 수백만 토큰 규모의 초장문 문맥(Long Context)을 다루는 AI 모델에 최적화된 것이 특징입니다.

여러분들도 아시다시피, 전통적인 GPU/LLM 인프라는 4k~32k 토큰 정도의 컨텍스트 윈도만 지원하고, 현재 KV-Cache(Attention Key-Value 캐시)를 GPU 메모리에 저장하는 방식은 메모리 소모와 연산 비용이 기하급수적으로 증가하고 있는 것이 현실입니다.

이에 많은 AI 인프라와 개발자들은 GPU 메모리 부족 (Out-of-Memory), Attention 속도 급격 저하 (Quadratic Scaling) 및 Latency 증가 등으로 하드웨어 차원의 최적화 없이는 롱 컨텍스트 Reasoning/Agent 실행이 어려움을 겪고 있습니다.

그러므로 롱 컨텍스트 기술적 진화는 알고리즘과 하드웨어 측면에 볼 때, 알고리즘 측면에서는 FlashAttention, PagedAttention 같은 기법으로 메모리 접근을 최적화하고, RAG나 Agentic AI 등 외부 메모리 방식을 통해 전체 데이터를 넣지 않고 필요할 때만 불러오며, 임베딩과 요약 기반의 압축 컨텍스트 기술을 활용해 긴 입력을 효율적으로 다룹니다.

하드웨어 측면에서는 GPU 메모리 용량과 대역폭 확장이 핵심 과제로 떠올랐습니다. 이번에 공개된 Rubin CPX는 무려 128GB GDDR7 메모리와 1.7PB/s 대역폭을 제공하여 기존 KV-cache 메모리 병목을 크게 완화했습니다. 또한 Attention 전용 연산 액셀레이터를 내장해 100만 토큰 단위의 추론을 실시간으로 처리할 수 있습니다.

이러한 기술 배경에서 Rubin CPX의 등장은, 단순히 “GPU 업그레이드”가 아니라, gent의 장기간 작업 맥락을 유지하는 데 최적화된 추론 메모리 전용 GPU입니다. 즉, 롱 컨텍스트 시대의 Reasoning + Agent AI를 위한 필수 인프라라고 마켓 포지션을 가질 수 있습니다. 성능 면에서도 압도적입니다.

GPU 한 개당 30 petaFLOPS에 달하는 NVFP4 연산 성능을 제공하며, 128GB GDDR7 메모리를 탑재해 기존 GB300 대비 3배 빠른 Attention 연산 속도를 구현합니다. 이는 단순히 처리 속도를 높이는 수준을 넘어, AI 추론의 스케일 자체를 확장하는 의미를 가집니다.

Rubin CPX는 단일 GPU 성능에 머무르지 않고, CPU인 Vera와 Rubin GPU를 함께 통합한 Vera Rubin NVL144 CPX 시스템으로도 제공됩니다. 이 시스템은 8 ExaFLOPS의 AI 성능과 100TB 메모리, 그리고 1.7PB/s에 달하는 메모리 대역폭을 갖추고 있으며, 전 세대 대비 무려 7.5배 향상된 성능을 보여줍니다. 이를 통해 기업과 연구소는 초대형 모델을 실제 서비스 환경에서 안정적으로 활용할 수 있습니다.

또한 Rubin CPX는 텍스트 추론을 넘어 비디오 처리와 장기 문맥 기반 추론에도 특화되어 있습니다. 고속 비디오 인코딩과 디코딩, 그리고 긴 맥락을 유지하는 추론 기능을 동시에 제공해 영상 검색이나 생성형 비디오 워크플로우와 같은 차세대 AI 활용 분야에서도 강력한 성능을 발휘합니다.

결국 Rubin CPX는 AI가 이해하고 기억할 수 있는 범위를 획기적으로 넓히며, 텍스트와 영상 등 멀티모달 환경을 아우르는 새로운 AI 추론 시대를 여는 핵심 기술로 자리 잡게 될 것입니다. NVIDIA는 Rubin CPX를 통해 100M 달러 투자 시, 5B 달러의 토큰 수익을 창출할 수 있다고 전망했습니다.

다시 말해, 단순히 기술 혁신이 아니라 새로운 비즈니스 모델의 핵심 인프라가 될 수 있다는 의미입니다. 끝으로 한 걸음만 뒤로 물러서 이 거대한 변화의 이면에 숨겨진 우리가 꼭 생각해 봐야 할 질문들을 던져 볼까 합니다. 이 상상을 초월하는 성능을 내기 위해서 대체 얼마나 많은 전기가 필요하고 그 환경적인 비용은 또 누가 감당해야 할까요? 과연 엔비디아의 이 독주를 막을 경쟁자는 나타날 수 있을까요?

그리고 어쩌면 가장 중요한 질문을 텐데요.

AI가 한 사람의 인생 전체 기록을 이해하고 그걸 바탕으로 콘텐츠를 만들어내는 시대에 과연 우리 인간의 역할은 무엇이 될까요? 결국 루빈 CPX가 던지는 건 단순히 기술의 미래에 대한 질문이 아닙니다. 바로 우리 자신에게 던지는 질문입니다. 여러분은 어떻게 생각하시나요?

엔비디아, 루빈 CPX 공개: 대규모 컨텍스트 추론을 위한 새로운 GPU 클래스

2025년 9월 9일

뉴스 요약

NVIDIA Rubin CPX GPU는 백만 토큰 코딩 및 생성형 비디오 애플리케이션을 처리하기 위해 설계됨.

NVIDIA Vera Rubin NVL144 CPX 플랫폼은 단일 랙에 8엑사플롭스의 AI 성능과 100TB의 고속 메모리를 제공.

기업들은 1억 달러 투자당 50억 달러 규모의 토큰 수익 창출 가능.

Cursor, Runway, Magic 같은 AI 혁신 기업들이 Rubin CPX의 애플리케이션 가속 가능성을 탐구 중.

AI Infra Summit에서 엔비디아(NVIDIA®)는 대규모 컨텍스트 처리를 위해 설계된 새로운 클래스의 GPU NVIDIA Rubin CPX를 발표했다. 이는 AI 시스템이 백만 토큰 규모의 소프트웨어 코딩 및 생성형 비디오를 혁신적인 속도와 효율로 처리할 수 있게 한다.

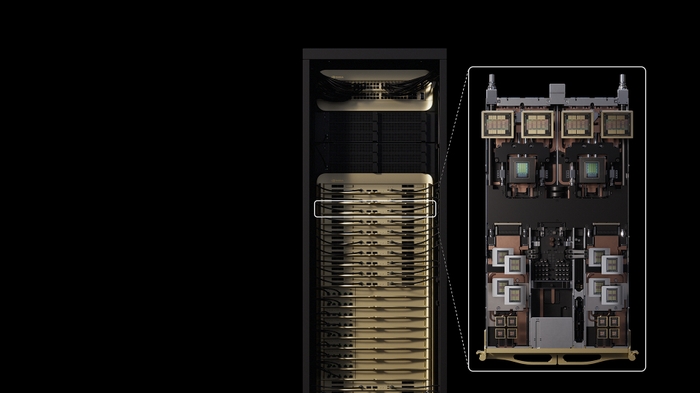

Rubin CPX는 새로운 NVIDIA Vera Rubin NVL144 CPX 플랫폼 내에서 NVIDIA Vera CPU 및 Rubin GPU와 함께 작동한다. 이 통합된 NVIDIA MGX 시스템은 단일 랙에서 8엑사플롭스의 AI 연산 성능을 제공하여 기존 NVIDIA GB300 NVL72 시스템 대비 7.5배 높은 AI 성능을 달성하며, 100TB의 고속 메모리와 초당 1.7페타바이트의 메모리 대역폭을 제공한다. 기존 Vera Rubin NVL144 시스템을 재활용하려는 고객을 위해 Rubin CPX 전용 컴퓨트 트레이도 제공된다.

엔비디아 창립자 겸 CEO 젠슨 황(Jensen Huang)은 다음과 같이 말했다.

“Vera Rubin 플랫폼은 AI 컴퓨팅의 새로운 도약을 보여줄 것입니다. 차세대 Rubin GPU와 CPX라는 새로운 범주의 프로세서를 함께 선보이는 것이죠. RTX가 그래픽과 물리 AI를 혁신한 것처럼, Rubin CPX는 수백만 토큰의 지식을 동시에 추론하는 대규모 컨텍스트 AI를 위해 처음으로 설계된 CUDA GPU입니다.”

NVIDIA Rubin CPX는 기존 시스템이 감당할 수 없던 긴 컨텍스트 처리를 통해 최고의 성능과 토큰 수익성을 제공한다. 이는 단순한 코드 생성 도구에 불과했던 AI 코딩 어시스턴트를 대규모 소프트웨어 프로젝트를 이해하고 최적화할 수 있는 정교한 시스템으로 변모시킨다.

비디오 처리의 경우, AI 모델이 1시간 분량의 콘텐츠를 위해 최대 100만 토큰을 필요로 하며 이는 기존 GPU 연산의 한계를 초월한다. Rubin CPX는 비디오 디코더와 인코더, 그리고 장기 컨텍스트 추론 프로세싱을 단일 칩에 통합하여 비디오 검색 및 고품질 생성형 비디오 같은 장기 포맷 애플리케이션에서 전례 없는 역량을 제공한다.

Rubin CPX의 기술 혁신

최대 30 페타플롭스 NVFP4 연산 성능 제공, 고정밀·고성능 AI 추론 지원.

128GB GDDR7 메모리로 대규모 컨텍스트 기반 워크로드 가속.

NVIDIA GB300 NVL72 대비 3배 빠른 어텐션 성능으로 긴 컨텍스트 시퀀스 처리 속도 유지.

다양한 구성 제공: Vera Rubin NVL144 CPX는 NVIDIA Quantum-X800 InfiniBand, NVIDIA Spectrum-X™ Ethernet 및 ConnectX®-9 SuperNICs™와 함께 확장 가능.

1억 달러 투자당 50억 달러 토큰 수익 창출 가능한 비즈니스 모델 제시.

산업계 반응

Cursor (AI 코드 에디터): Rubin CPX로 개발자 생산성을 극대화해 더 빠르고 협업적인 코드 작성 환경 제공.

Runway (생성형 비디오): 장기 컨텍스트 기반 에이전트형 워크플로우를 지원해 창작자들이 영화 수준의 콘텐츠를 빠르고 정밀하게 제작할 수 있게 함.

Magic (AI 에이전트 연구): 1억 토큰 컨텍스트 윈도우로 코드베이스·문서·라이브러리를 한 번에 처리 가능, 자율형 에이전트 경험을 앞당김.

소프트웨어 지원

Rubin CPX는 엔비디아 AI 스택 전체와 호환된다.

NVIDIA Dynamo 플랫폼: AI 추론 확장, 처리량 극대화, 지연시간 및 모델 운영 비용 절감.

NVIDIA Nemotron™ 모델군: 기업용 AI 에이전트를 위한 최신 멀티모달 추론 모델 제공.

NVIDIA AI Enterprise: NIM™ 마이크로서비스, 라이브러리 및 프레임워크 포함, 클라우드·데이터센터·워크스테이션에 즉시 배포 가능.

CUDA-X™ 생태계: 600만 명 이상의 개발자 및 약 6,000개 애플리케이션 지원.

출시 일정

NVIDIA Rubin CPX는 2026년 말 출시 예정.

NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference

News Summary:

- The NVIDIA Rubin CPX GPU is purpose-built to handle million-token coding and generative video applications.

- The NVIDIA Vera Rubin NVL144 CPX platform packs 8 exaflops of AI performance and 100TB of fast memory in a single rack.

- Companies can monetize at an unprecedented scale, with $5B in token revenue for every $100M invested.

- AI innovators like Cursor, Runway and Magic are exploring how Rubin CPX can accelerate their applications.

AI Infra Summit—NVIDIA® today announced NVIDIA Rubin CPX, a new class of GPU purpose-built for massive-context processing. This enables AI systems to handle million-token software coding and generative video with groundbreaking speed and efficiency.

Rubin CPX works hand in hand with NVIDIA Vera CPUs and Rubin GPUs inside the new NVIDIA Vera Rubin NVL144 CPX platform. This integrated NVIDIA MGX system packs 8 exaflops of AI compute to provide 7.5x more AI performance than NVIDIA GB300 NVL72 systems, as well as 100TB of fast memory and 1.7 petabytes per second of memory bandwidth in a single rack. A dedicated Rubin CPX compute tray will also be offered for customers looking to reuse existing Vera Rubin NVL144 systems.

“The Vera Rubin platform will mark another leap in the frontier of AI computing — introducing both the next-generation Rubin GPU and a new category of processors called CPX,” said Jensen Huang, founder and CEO of NVIDIA. “Just as RTX revolutionized graphics and physical AI, Rubin CPX is the first CUDA GPU purpose-built for massive-context AI, where models reason across millions of tokens of knowledge at once.”

NVIDIA Rubin CPX enables the highest performance and token revenue for long-context processing — far beyond what today’s systems were designed to handle. This transforms AI coding assistants from simple code-generation tools into sophisticated systems that can comprehend and optimize large-scale software projects.

To process video, AI models can take up to 1 million tokens for an hour of content, pushing the limits of traditional GPU compute. Rubin CPX integrates video decoder and encoders, as well as long-context inference processing, in a single chip for unprecedented capabilities in long-format applications such as video search and high-quality generative video.

Built on the NVIDIA Rubin architecture, the Rubin CPX GPU uses a cost‑efficient, monolithic die design packed with powerful NVFP4 computing resources and is optimized to deliver extremely high performance and energy efficiency for AI inference tasks.

Advancements Offered by Rubin CPX

Rubin CPX delivers up to 30 petaflops of compute with NVFP4 precision for the highest performance and accuracy. It features 128GB of cost-efficient GDDR7 memory to accelerate the most demanding context-based workloads. In addition, it delivers 3x faster attention capabilities compared with NVIDIA GB300 NVL72 systems — boosting an AI model’s ability to process longer context sequences without a drop in speed.

Rubin CPX is offered in multiple configurations, including the Vera Rubin NVL144 CPX, that can be combined with the NVIDIA Quantum‑X800 InfiniBand scale-out compute fabric or the NVIDIA Spectrum-X™ Ethernet networking platform with NVIDIA Spectrum-XGS Ethernet technology and NVIDIA ConnectX®-9 SuperNICs™. Vera Rubin NVL144 CPX enables companies to monetize at an unprecedented scale, with $5 billion in token revenue for every $100 million invested.

Industry Leaders Look to Rubin CPX

AI innovators are exploring how Rubin CPX can accelerate their applications, ranging from large-scale software development to the analysis of dynamic visual content to better understand moving images.

Cursor, an AI-powered software company that offers an advanced code editor, sees the benefits of Rubin CPX to boost developer productivity with intelligent code generation and collaborative tools directly in the coding environment.

“With NVIDIA Rubin CPX, Cursor will be able to deliver lightning-fast code generation and developer insights, transforming software creation,” said Michael Truell, CEO of Cursor. “This will unlock new levels of productivity and empower users to ship ideas once out of reach.”

Runway, an American generative AI company, will use NVIDIA technologies to enable creators to produce cinematic content and sophisticated visual effects with unmatched scale and efficiency.

“Video generation is rapidly advancing toward longer context and more flexible, agent-driven creative workflows,” said Cristóbal Valenzuela, CEO of Runway. “We see Rubin CPX as a major leap in performance, supporting these demanding workloads to build more general, intelligent creative tools. This means creators — from independent artists to major studios — can gain unprecedented speed, realism and control in their work.”

Magic is an AI research and product company developing foundation models to power AI agents that can automate software engineering.

“With a 100-million-token context window, our models can see a codebase, years of interaction history, documentation and libraries in context without fine-tuning,” said Eric Steinberger, CEO of Magic. “This enables users to coach the agent at test time through conversation and access to their environments, bringing us closer to autonomous agentic experiences. Using a GPU like NVIDIA Rubin CPX greatly accelerates our compute workloads.”

Software Support

NVIDIA Rubin CPX will be supported by the complete NVIDIA AI stack — from accelerated infrastructure to enterprise‑ready software. The NVIDIA Dynamo platform efficiently scales AI inference, dramatically boosting throughput while cutting response times and model serving costs.

The processors will be able to run the latest in the NVIDIA Nemotron™ family of multimodal models that provide state-of-the-art reasoning for enterprise-ready AI agents. For production-grade AI, Nemotron models can be delivered with NVIDIA AI Enterprise, a software platform that includes NVIDIA NIM™ microservices as well as AI frameworks, libraries and tools that enterprises can deploy on NVIDIA-accelerated clouds, data centers and workstations.

Built on decades of innovation, the Rubin platform extends NVIDIA’s developer ecosystem — with NVIDIA CUDA‑X™ libraries, a community of over 6 million developers and nearly 6,000 CUDA applications.

Availability

NVIDIA Rubin CPX is expected to be available at the end of 2026.

[테크수다 기자 도안구 eyeball@techsuda.com]