[AWS re:Invent 2022] ARM 기반 그래비톤 칩으로 비용과 성능 모두 잡는다ㆍㆍㆍ인텔ㆍAMDㆍ엔비디아 정조준

[테크수다 기자 도안구] 아마존웹서비스가 비용 절감 이슈에 대해 ARM 기반 CPU인 그래비톤 칩 새로운 버전을 내놓으며 돌파구를 마련하고 있다. 인텔과 AMD, 엔비디아 기반 인스턴스를 자사의 새로운 서버 칩이 탑재된 인스턴스로 옮기는 것만으로도 고객의 운영 비용을 대폭 낮출 수 있다고 강조한다.

아마존웹서비스(Amazon Web Services, 이하 AWS)는 AWS 리인벤트(AWS re:Invent) 행사에서 3개의 새로운 아마존 일래스틱 컴퓨트 클라우드(Amazon Elastic Compute Cloud, 이하 아마존 EC2) 인스턴스를 발표했다.

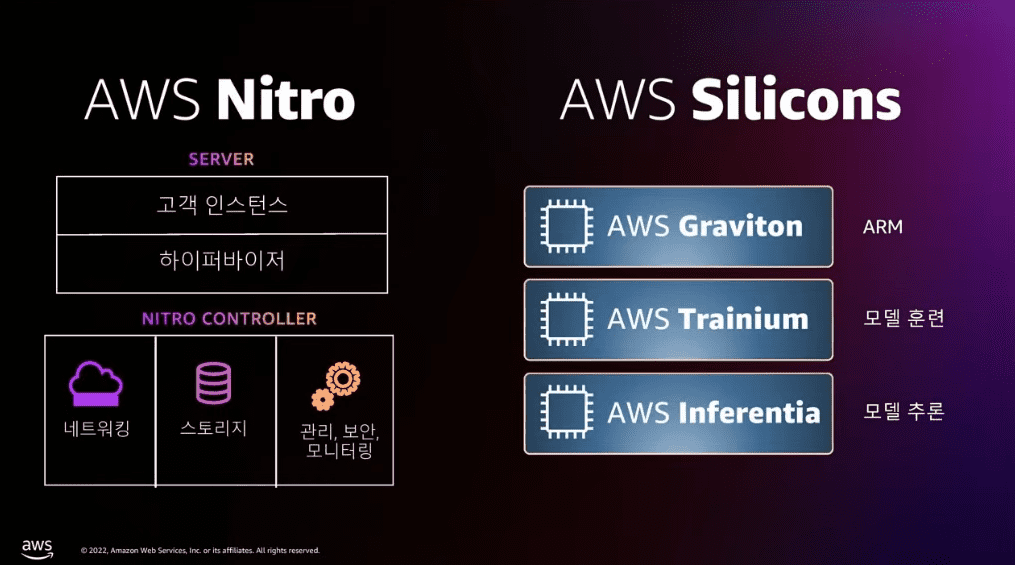

데이비드 브라운(David Brown) AWS 아마존 EC2 담당 부사장은 "그래비톤에서 트레이니엄과 인퍼런시아 칩, 니트로 카드에 이르기까지 AWS 자체 설계 실리콘 각 세대는 다양한 고객 워크로드에 대해 향상된 수준의 성능, 저렴한 비용, 전력 효율성을 제공한다”며 “이러한 일관된 지원과 더불어 AWS 실리콘을 사용해 월등한 가격 대비 성능을 달성하는 고객의 역량은 지속적인 혁신으로 이어진다. 오늘 소개하는 아마존 EC2 인스턴스는 HPC, 네트워크 집약 및 ML 추론 워크로드에 대한 상당한 개선을 제공하여, 고객이 특정 니즈를 충족하기 위해 선택할 수 있는 인스턴스 옵션을 증대했다"고 말했다.

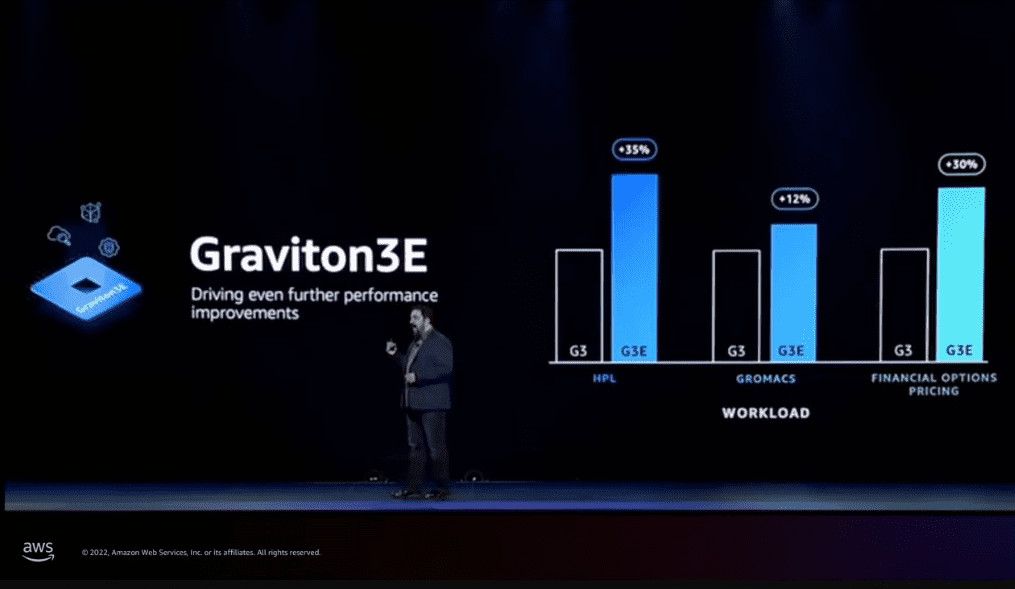

3개의 새로운 AWS 자체 설계 칩으로 구동되는 신규 인스턴스는 광범위한 워크로드에 대해 더 낮은 비용으로 더 뛰어난 컴퓨팅 성능을 고객에 제공한다. 새로운 AWS 그래비톤3E(Graviton3E) 칩으로 구동되는 Hpc7g 인스턴스는 현재 세대 C6gn 인스턴스에 비해 최대 2배 높은 부동소수점 성능과, 현재 세대 Hpc6a 인스턴스 대비 최대 20% 더 높은 성능을 구현하여 AWS에서의 고성능 컴퓨팅(high performance computing, HPC) 워크로드를 위한 최고의 가격 대비 성능을 제공한다.

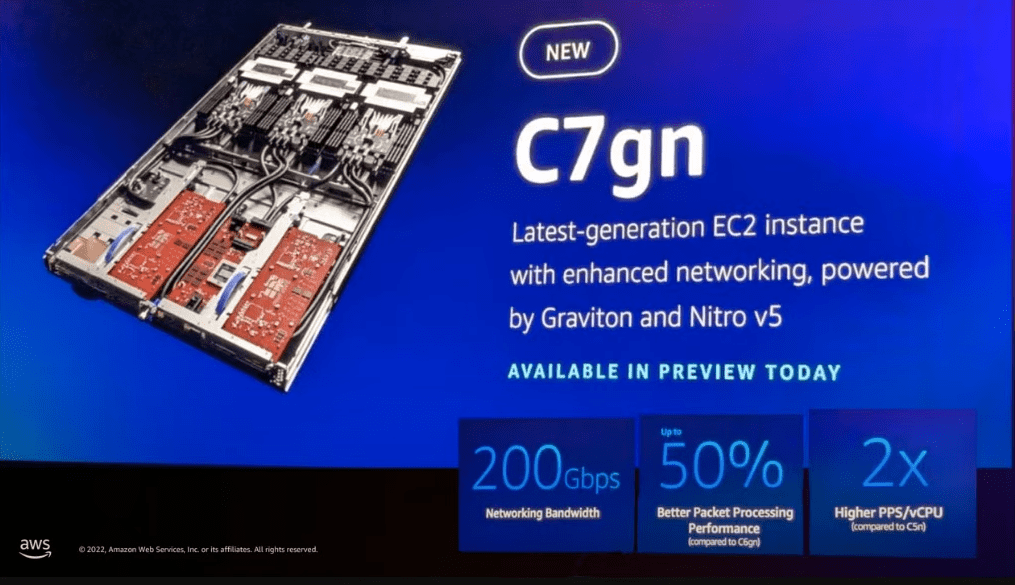

새로운 AWS 니트로 카드(Nitro Cards)를 탑재한 C7gn 인스턴스는 현재 세대의 네트워킹에 최적화된 인스턴스 대비 CPU당 최대 2배의 네트워크 대역폭과 최대 50% 향상된 초당 패킷 처리 성능을 구현하여 최고 수준의 네트워크 대역폭과 패킷 속도 및 네트워크 집약적 워크로드를 위한 최고의 가격 대비 성능을 제공한다. 새로운 AWS 인퍼런시아2(Inferentia2) 칩으로 구동되는 Inf2 인스턴스는 최대 1,750억 개의 파라미터를 가진 최대 규모의 딥 러닝 모델을 실행하도록 구축되었으며, 현재 세대 Inf1 인스턴스 대비 최대 4배 높은 처리량과 최대 10배 낮은 지연 시간을 제공하여 아마존 EC2에서의 머신 러닝(ML) 추론에 대해 최저 비용으로 최저 지연 시간을 구현한다.

AWS는 지난 10년간 클라우드에서 더 저렴한 비용으로 성능과 확장성을 제공하기 위해 특화된 칩을 설계한 경험을 보유하고 있다. AWS는 더 빠른 처리, 더 높은 메모리 용량, 더 빠른 스토리지 I/O, 증가된 네트워킹 대역폭 등을 필요로 하는 다양한 특성에 맞춰 고객이 훨씬 더 까다로운 워크로드를 실행할 수 있게 하는 특수 칩 설계를 시작했다. 2013년 AWS 니트로 시스템을 도입한 이후, AWS는 니트로 시스템 5세대, 다양한 워크로드에 대한 성능과 비용에 최적화된 그래비톤 칩 3세대, ML 추론용 인퍼런시아 칩 2세대, ML 교육용 트레이니엄(Trainium) 칩 등 혁신적인 자체 설계 실리콘을 다수 개발했다. AWS는 자체 설계한 실리콘의 설계와 검증을 위한 애자일 개발 주기의 일환으로 클라우드 기반 전자 설계 자동화(Electronic Design Automation, EDA)를 사용하여, 팀이 더 빠르게 혁신하고 고객에게 더 빨리 칩을 제공할 수 있도록 한다. AWS는 보다 현대적이고 전력 효율적인 실리콘 프로세스를 기반으로 예측 가능하고 빠른 속도로 새로운 칩을 제공할 수 있다. 각 최신 세대의 칩을 통해 AWS는 이를 호스팅하는 아마존 EC2 인스턴스에 대한 성능, 비용, 전력 효율성의 단계적 개선을 제공함으로써, 고객의 고유한 워크로드 요구 사항에 최적화된 칩과 인스턴스의 보다 많은 조합을 제공한다.

Hpc7g 인스턴스, 아마존 EC2에서 HPC 워크로드를 대규모로 실행하기 위한 최고의 가격 대비 성능을 제공하도록 설계

다양한 분야의 기관들은 가장 복잡한 학문, 과학, 비즈니스 문제를 해결하기 위해 HPC에 의존하고 있다. 현재 아스트라제네카(AstraZeneca), 포뮬러 원(Formula 1), 맥사 테크놀로지(Maxar Technologies)와 같은 고객은 유전체학 처리, 전산 유체 역학(CFD), 일기 예보 시뮬레이션과 같은 기존 HPC 워크로드를 AWS 상에서 실행하여 AWS가 제공하는 우수한 보안성, 확장성, 탄력성을 활용하고 있다. 엔지니어, 연구원, 과학자들은 수천 개의 코어에서 데이터를 처리하고 교환하는 서버 간에 사실상 무제한 컴퓨팅 용량과 높은 수준의 네트워크 대역폭을 제공하는 네트워크에 최적화된 아마존 EC2 인스턴스(예: Hpc6a, Hpc6id, C5n, R5n, M5n, C6gn)에서 HPC 워크로드를 실행한다. 이러한 인스턴스의 성능은 오늘날 대부분의 HPC 사용 사례에 있어 충분하지만, 인공 지능(AI)이나 자율주행 자동차와 같이 새롭게 떠오르는 애플리케이션은 점점 더 어려워지는 문제를 해결하고 수만 개 이상의 코어로 확장할 수 있는 HPC 워크로드의 비용을 줄이기 위해 추가로 확장가능한 HPC 최적화 인스턴스를 필요로 한다.

새로운 AWS 그래비톤3E 프로세서로 구동되는 Hpc7g 인스턴스는 아마존 EC2 상에서 고객의 HPC 워크로드(예: 전산 유체 역학(CFD), 날씨 시뮬레이션, 유전체학, 분자 역학)에 대해 최고의 가격 대비 성능을 제공한다. Hpc7g 인스턴스는 그래비톤2 프로세서로 구동되는 현재 세대 C6gn 인스턴스에 비해 최대 2배 향상된 부동소수점 연산 성능을 제공하고, 현재 세대 Hpc6a 인스턴스 대비 최대 20% 높은 성능을 제공하므로 고객은 최대 수만 개 코어로 구성된 HPC 클러스터에서 복잡한 계산을 수행할 수 있다. 또한 Hpc7g 인스턴스는 모든 AWS 인스턴스 유형에서 높은 메모리 대역폭과 200Gbps 엘라스틱 패브릭 어댑터(EFA) 네트워크 대역폭을 제공하므로 HPC 애플리케이션의 결과를 더 빨리 얻을 수 있다. 고객은 오픈소스 클러스터 관리 도구인 AWS 패러렐클러스터(ParallelCluster)와 함께 Hpc7g 인스턴스를 사용하여 다른 인스턴스 유형과 함께 Hpc7g 인스턴스를 프로비저닝할 수 있게 되어, 동일한 HPC 클러스터 내에서 다양한 워크로드 유형을 실행할 수 있는 유연성을 제공한다. AWS의 HPC에 대한 자세한 내용은 웹사이트(aws.amazon.com/hpc.)에서 확인할 수 있다.

C7gn 인스턴스, 더 높은 네트워킹 대역폭과 더 큰 패킷 속도 성능 그리고 더 짧은 지연 시간으로 네트워크 집약적인 워크로드에 최고 성능 제공

고객은 아마존 EC2 네트워크 최적화 인스턴스를 사용하여 네트워크 가상 어플라이언스(예: 방화벽, 가상 라우터, 로드 밸런서)나 데이터 암호화와 같이 가장 까다로운 네트워크 집약적 워크로드를 실행한다. 고객은 활동 급증에 대응하여 늘어난 네트워크 트래픽을 처리하거나 최종 사용자에게 더 나은 경험을 제공하기 위해 처리 시간을 줄이기 위해서 이러한 워크로드의 성능을 확장해야 한다. 오늘날 고객은 더 큰 인스턴스를 사용하여 더 많은 네트워크 처리량을 얻고 필요한 것보다 더 많은 컴퓨팅 리소스를 배포하므로 비용이 증가한다. 따라서 고객은 데이터 처리 시간을 줄이기 위해 향상된 초당 패킷 성능, 더 높은 네트워크 대역폭, 더 빠른 암호화 성능이 필요하다.

네트워크 가속 기능이 있는 새로운 5세대 니트로 AL10 칩으로 구동되는 새로운 AWS 니트로 카드를 포함한 C7gn 인스턴스는 아마존 EC2 네트워크 최적화 인스턴스에서 최고 수준의 네트워크 대역폭과 패킷 처리 성능을 제공하며, 동시에 사용 전력을 줄인다. 니트로 카드는 호스트 CPU에서 특수 하드웨어로 기능에 대한 I/O를 오프로드하고 가속화하여 거의 모든 아마존 EC2 인스턴스 리소스를 고객 워크로드에 제공함으로써 CPU 사용률은 낮추면서 보다 일관된 성능을 제공한다. 새로운 AWS 니트로 카드를 통해 C7gn 인스턴스는 CPU 당 최대 2배의 네트워크 대역폭과 최대 50% 향상된 초당 패킷 처리 성능을 구현하며, 현재 세대 네트워킹에 최적화된 아마존 EC2 인스턴스와 비교하여 EFA(Elastic Fabric Adapter) 네트워크 지연 시간을 줄일 수 있다. 또한, 5세대 Nitro 카드는 4세대와 비교해 와트당 성능이 40% 향상되어 워크로드 전력 소비를 낮춘다. 또한 C7gn 인스턴스는 C6gn 인스턴스에 비해 암호화 워크로드에 대해 최대 25% 향상된 컴퓨팅 성능과 최대 2배 더 빠른 성능을 제공한다. C7gn 인스턴스를 사용하면 고객은 성능과 처리량을 모두 늘리고 네트워크 지연 시간을 줄여 아마존 EC2에서 가장 까다롭고 네트워크 집약적인 워크로드의 비용을 최적화할 수 있다. 현재 C7gn 인스턴스는 프리뷰로 제공된다. C7gn 인스턴스에 대한 자세한 내용은 aws.amazon.com/ec2/instance-types/c7g에서 확인할 수 있다.

Inf2 인스턴스, 분산 추론과 확률적 반올림 지원으로 가장 까다로운 딥 러닝 모델 배포를 지원하도록 설계

더 나은 애플리케이션과 더욱 맞춤화된 경험에 대한 요구를 수용하기 위해 데이터 사이언티스트와 ML 엔지니어들은 더 크고 복잡한 딥 러닝 모델을 구축하고 있다. 예를 들어, 1,000억 개 이상의 파라미터를 포함하는 LLM(대규모 언어 모델)이 점점 더 널리 보급되고 있지만 엄청난 양의 데이터에 대한 훈련으로 인해 컴퓨팅 요구 사항이 전례 없이 증가하고 있다. 훈련이 많은 관심을 받고 있는 한편, 추론은 프로덕션에서 머신 러닝을 실행하는 복잡성과 비용(예: 훈련에 1달러를 지출할 때마다 추론에 최대 9달러가 소요됨)의 대부분을 차지하므로 사용이 제한되고 고객 혁신을 지연시킬 수 있다. 고객은 대규모 애플리케이션에서 최첨단 딥 러닝 모델을 사용하기를 원하지만 높은 컴퓨팅 비용으로 인해 제약을 받는다. 지난 2019년, AWS가 Inf1 인스턴스를 출시했을 때 딥 러닝 모델의 파라미터는 수백만 개였다. 이후, 딥 러닝 모델의 크기와 복잡성은 기하급수적으로 증가하여 일부 딥 러닝 모델은 파라미터 수가 500배 이상 늘어난 수천억 개에 달한다. 딥 러닝의 최신 기술을 사용하여 차세대 애플리케이션을 작업하는 고객은 엔지니어링 팀이 최신 혁신을 대규모로 신속하게 배포할 수 있도록 유연한 소프트웨어와 짧은 지연 시간, 높은 처리량 추론을 지원하는 비용 효율적이고 에너지 효율적인 하드웨어를 원한다.

새로운 인퍼런시아2 칩으로 구동되는 Inf2 인스턴스는 최대 1,750억 개의 파라미터를 가진 대규모 딥 러닝 모델(예: LLM, 이미지 생성, 자동 음성 감지)을 지원하는 동시에, 아마존 EC2에서 가장 낮은 추론당 비용을 제공한다. Inf2는 1,000억 개 이상의 파라미터를 가진 딥 러닝 모델에 최고의 성능을 제공하기 위해 여러 칩에 대규모 모델을 분산시키는 기술인 분산 추론을 지원하는 최초의 추론 최적화 아마존 EC2 인스턴스다. 또한 Inf2 인스턴스는 기존 반올림 모드에 비해 성능과 정확도를 높여주는 확률적 반올림을 지원하는 첫 번째 클라우드 인스턴스다. Inf2 인스턴스는 처리량을 향상하고 추론당 전력을 줄이는 CFP8과 아직 정밀도가 낮은 데이터 유형을 활용하지 않은 모듈의 성능을 향상시키는 FP32를 비롯한 다양한 데이터 유형을 지원한다. 고객은 ML 추론용 통합 소프트웨어 개발 키트(SDK)인 AWS 뉴런(AWS Neuron)을 사용하여 Inf2 인스턴스를 시작할 수 있다. AWS 뉴런은 파이토치(PyTorch)나 텐서플로우(TensorFlow)와 같은 인기 있는 ML 프레임워크와 통합되어 고객이 최소한의 코드 변경으로 기존 모델을 Inf2 인스턴스에 배포할 수 있도록 지원한다. 대규모 모델을 여러 칩으로 분할하려면 칩 간에 빠른 통신이 필요하므로 Inf2 인스턴스는 초당 192GB의 링 연결을 제공하는 AWS의 인스턴스 내 고속 인터커넥트인 뉴런링크(NeuronLink)를 지원한다. Inf2 인스턴스는 현재 세대 Inf1 인스턴스에 비해 처리량은 최대 4배 높고, 지연 시간은 최대 10배 낮으며 GPU 기반 인스턴스에 비해 와트당 성능이 최대 45% 향상됐다. 현재 Inf2 인스턴스는 프리뷰로 제공된다. Inf2 인스턴스에 대한 자세한 내용은 aws.amazon.com/ec2/instance-types/inf2에서 확인할 수 있다.

에이럽(Arup)은 지속가능한 개발과 상상력, 기술, 엄격함을 기반으로 더 나은 세상을 만들기 위해 노력하는 디자이너, 엔지니어링, 지속가능성 컨설턴트, 고문 및 전문가로 구성된 글로벌 기업이다.

시나 하산리(Sina Hassanli), 에이럽 수석 엔지니어 박사는 "에이럽은 AWS를 활용하여 고도로 복잡한 CFD 시뮬레이션을 실행해 고객이 차세대 고층 건물, 경기장, 데이터센터 등 중요한 인프라를 구축할 수 있도록 돕고 전 세계의 수많은 사람들의 삶에 영향을 미치는 도시 미기후, 지구 온난화, 기후 변화를 평가하고 통찰력을 제공한다. 고객은 개발 초기 단계에서 설계에 정보를 제공하기 위해 더 빠르고 정확한 시뮬레이션을 더 저렴한 비용으로 구현하기를 계속 요구하고 있으며, 더 높은 성능의 아마존 EC2 Hpc7g 인스턴스 도입이 고객이 더 빠르고 더 효율적으로 혁신하는 데 어떻게 도움이 될지 벌써 기대가 된다"고 말했다.

[테크수다 기자 도안구 eyeball@techsuda.com]

관련 기사

[AWS re:Invent 2022] 세이지메이커를 위한 8가지 신규 기능 발표 – 테크수다 (techsuda.com)

[AWS re:Invent 2022] 서플라이 체인 발표 – 테크수다 (techsuda.com)

[AWS re:Invent 2022] 5가지 DB·분석 기능 발표 – 테크수다 (techsuda.com)

[AWS re:Invent 2022] ARM 기반 그래비톤 칩으로 비용과 성능 모두 잡는다ㆍㆍㆍ인텔ㆍAMDㆍ엔비디아 정조준 – 테크수다 (techsuda.com)