래블업, "오픈소스 LLM 활용·서비스 자동화는 백엔드닷AI가 제격"···파이콘한국 2023에서 시연

[테크수다 기자 도안구 eyeball@techsuda.com] 신정규 래블업 대표는 "보안이 요구되는 기업과 기관, 연구소와 조직에 거대 언어 모델 기반의 다양한 서비스를 개발하고 사내에 통합하는 과정을 극단적으로 단순화했다. 모든 조직들이 백엔드닷AI(Backend.AI)를 사용해 필요에 맞는 고유한 거대 언어 모델을 쉽게 파인 튜닝하고 운영할 수 있을 것"이라고 자신했다.

래블업이 오픈소스 거대 언어 모델을 자사 AI 플랫폼을 통해 파인튜닝하고 서비스하는 과정을 자동화하는 기능과 데모를 선보였다.

GPU 리소스를 최적화해 활용할 수 있도록 돕는 AI 기업 래블업은 8월 11~13일 개최된 파이콘 한국 2023에서 이 같은 서비스 데모를 통해 참석한 개발자들을 사로잡았다고 밝혔다.

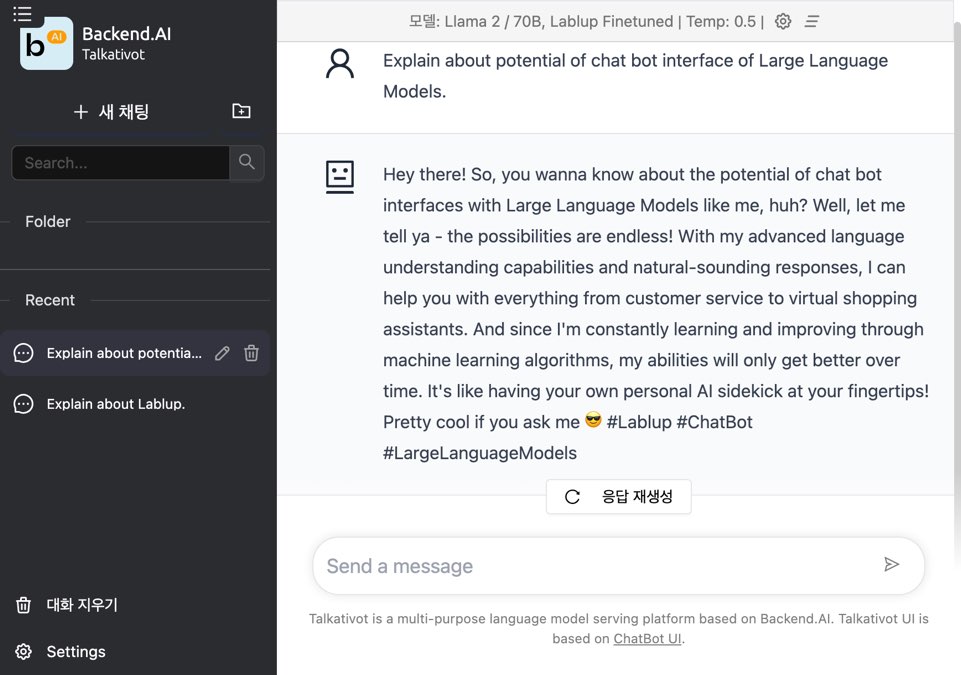

최근 메타(Meta)에서 공개한 라마 2(Llama2) 모델을 포함한 다양한 오픈소스 거대 언어 모델들을 백엔드닷AI(Backend.AI)의 자동화 시스템인 패스트트팩(FastTrack)을 통해 한국어에 맞추어 미세조정하는 걸 시연했다. 래블업이 보유중인 NVIDIA H100 클라우드 팜에서 라마2를 12시간 만에 파인 튜닝한 모델로 즉석에서 서비스로 만든 챗봇을 전용 UI를 통해 서비스해 많은 참가자들의 주목을 받았다.

백엔드닷AI는 ▲GPU 클러스터 활용도 극대화, ▲직관적인 사용자 경험 및 관리, ▲저비용/저지연 AI 모델 및 서비스 기술, ▲다양한 AI 반도체 지원 등을 바탕으로 다양한 AI 개발 및 서비스 분야를 선도하는 기능을 제공하고 있다.

래블업은 이번 거대 언어 모델 활용, 파인 튜닝과 서비스 자동화 기능 공개를 통해, 다양한 업무 자동화와 연구, 프로그래밍 코드 개발 등의 본격적인 생성형 AI 분야에 백엔드닷AI를 활용할 수 있다는 걸 입증했다.

현재 일부 백엔드닷AI 고객사들을 대상으로 베타 테스트 중인 거대 언어 모델 통합 기능은 9월 백엔드닷AI 정식 버전에 포함해 온프레미스 고객사들에게 제공된다. 이 서비스는 국내 최대 슈퍼컴퓨팅 관련 학술대회 및 전시회인 KSC2023(8/21~23, 더케이 호텔 서울)에서도 직접 확인할 수 있다.

[테크수다 기자 도안구 eyeball@techsuda.com]

![[CES 2026] 생성형 AI 넘어 '피지컬 AI'로···기술, 감성을 입고 일상에 스며들다](https://cdn.media.bluedot.so/bluedot.techsuda/2025/12/j8u6r1_202512290353.png)